De trends in het technologisch vakgebied gaan de komende jaren onze werkelijkheid flink veranderen. Waar verandering plaatsvindt is er ook mogelijkheid tot verbetering. Hoe kan ik als ontwerpend onderzoeker bijdragen aan de ethische en maatschappelijke belangen van artificiële intelligentie (AI)?

Products marketed as gender-neutral that are in fact biased towards men are rife across the (male-dominated) tech industry.

PEREZ

Tijdens het lezen van het boek Invisible Women, geschreven door Caroline Criado Perez, ontdekte ik de term ‘bias’. Bias is de vooringenomenheid die wij hebben over de wereld en mensen om ons heen. Perez geeft in haar boek veel voorbeelden over hoe bias een effect heeft op alle facetten in ons leven. Wat mij het meest intrigeerde in haar boek waren de voorbeelden rondom bias en de toekomst van technologie, zoals het feit dat spraakherkenning met 70% hogere waarschijnlijkheid mannelijke spraak herkent (Perez). Ik vroeg mij af waarom ik niemand hoorde praten over deze grote negatieve effecten van bias in technologie voor 50% van de bevolking?

Impact van bias in AI

Vanwege het gebrek aan bewustzijn over deze gevaren, ben ik mijn onderzoek gestart naar biases in Artificial Intelligence (AI) en welke impact die hebben op de maatschappij. Dit vanuit mijn perspectief als vrouw, en de potentiële gevaren die ik zie voor vrouwen doordat AI-systemen veelal gemaakt worden door een homogene groep namelijk witte hoogopgeleide mannen. Zodra er homogeniteit plaatsvindt binnen een vakgebied leidt dat tot een eenzijdig perspectief. Dat eenzijdige perspectief verhoudt zich tot de biases die een rol spelen bij deze homogene groep.

Zo is binnen het AI-vakgebied maar 14 procent vrouw (Stathoulopoulos, Mateos-Garcia), en een nog lager percentage vertegenwoordigt de diverse etnische achtergronden. Dit onderzoek naar biases in AI is zeker nodig als deze systemen een prominentere rol krijgen in onze maatschappij.

Biases zijn in zichzelf geen probleem, echter, zodra je een homogene groep laat werken in een vakgebied zie je dat die biases kunnen veranderen in het al dan niet opzettelijk uitsluiten van mensen, wat kan leiden tot seksisme, racisme of discriminatie.

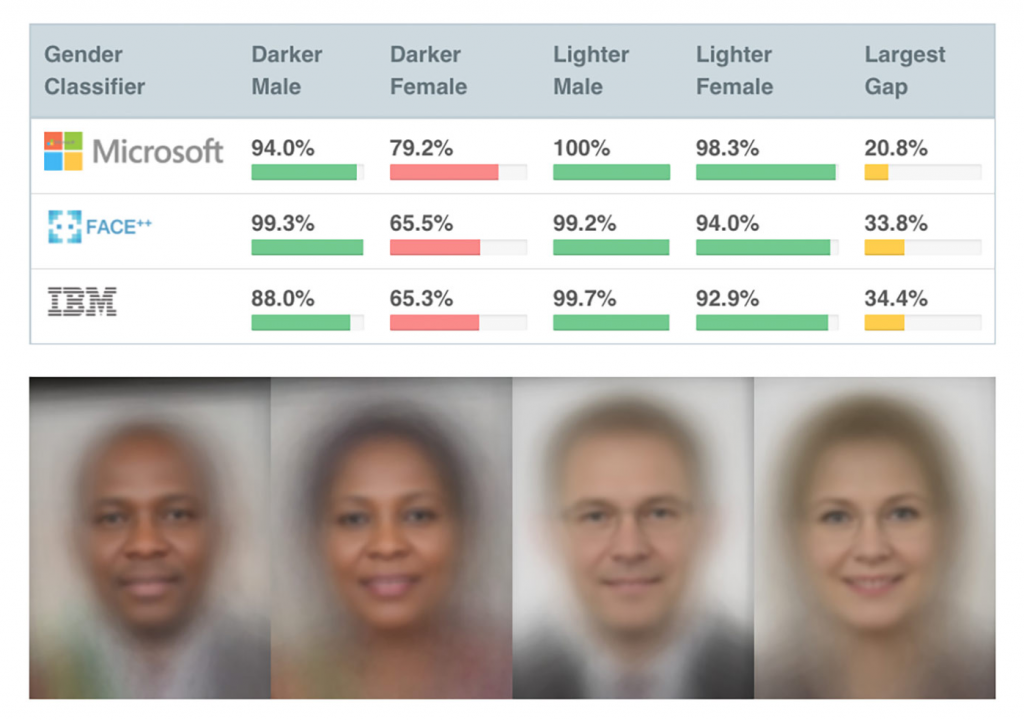

Een goed voorbeeld hiervan waren de AI-gezichtsherkenningsystemen van Microsoft en IBM die veel moeite hadden met het herkennen van zwarte vrouwen (Simonite). Er zat een onbewuste racial bias in de gebruikte foto’s: er zijn meer foto’s van witte mensen, en geen van de makers was een zwarte vrouw die het systeem hierop kon evalueren. Doordat het systeem voor de makers wel werkte dacht men onterecht dat ze het systeem uitgebreid hadden getest.

Het resulteerde in grote publieke verontwaardiging en imagoschade voor Microsoft en IBM, waarbij laatstgenoemde besloot te stoppen met het onderzoeken, maken en aanbieden van gezichtsherkenningsoftware (Peters). Voorbeelden als deze zijn de reden waarom ik onderzoek ben gaan doen naar de makers van AI-systemen, maar ook naar gebruikers. De vraag die mij vooral bezighoudt is wat we kunnen doen om die biases in AI-systemen te verminderen.

Lexicon

Bias

De vooringenomenheid van mensen tegenover iets of iemand. Sommige biases zijn positief, zoals het alleen maar willen eten van gezonde voeding. Vaak zijn biases echter gebaseerd op stereotypen. Dit kan (onbewuste) vooroordelen creëren die kunnen leiden tot discriminerend gedrag. Dit discriminerende gedrag wordt in sommige gevallen zelfs onbedoeld vastgelegd in discriminerende systemen en instituten.

Artificial Intelligence

AI (in het Nederlands: Kunstmatige Intelligentie) is een technologie waarbij computersystemen complexere taken uitvoeren en daarmee intelligenter worden. AI is adaptief en autonoom en het is voor de mensheid nu nog onbekend welke rol deze AI-technologie gaat innemen in de toekomst. Wat betekent het at een AI-systeem zonder menselijke interventie gaat leren en slimmer wordt.

Zelfbewustwording

Zelfbewustwording is inzicht en bewustzijn krijgen in wie je bent, en welke patronen en biases bepalen hoe je bewust of onbewust in het leven staat.

Zelfbewustwording leidt tot minder biased AI-systemen

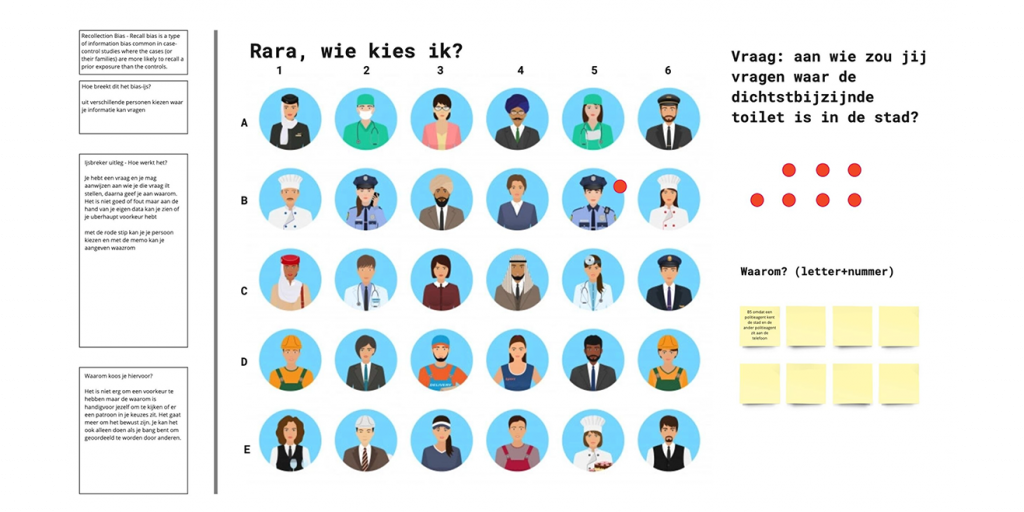

Mijn eerste iteratie bestond uit een workshop voor derdejaarsstudenten van de Hogeschool Rotterdam, designers of developers. Dit zijn de studenten die later makers worden van AI-systemen en daarmee een belangrijke groep voor mijn onderzoek.

Tijdens deze workshop heb ik heel bewust een strategie toegepast om een veilige en open omgeving te creëren, waarin iedereen zich vrij kon uiten. Dit heb ik gedaan door bias te positioneren als iets inherent menselijks;, iedereen brengt zijn eigen vooringenomenheid met zich mee. Tevens heb ik duidelijk gemaakt dat bias op zichzelf ook niet slecht is, heb ik bewust termen als ‘witte man’ achterwege gelaten, en heb ik alles gedaan om niet de indruk te wekken dat er een schuldige is. Dit zorgde voor eerlijke, gelijkwaardige discussies waarin iedereen open kon zijn. Discussies waarin ik zelf ook geregeld voorbeelden heb genoemd van hoe ik zelf biased, vooringenomen, ben.

“Mijn broer en ik worden anders behandeld doordat we er qua uiterlijk heel anders uit zien. Naast dat dat racistisch is, ontdek ik meer en meer hoeveel lagen daar nog meer onder zitten en op welke manier ik zelf biased ben en er misschien wel aan bijdraag“

Deze veilige en open omgeving zorgde er vervolgens voor dat de participanten zich voldoende op hun gemak voelden om introspectief en kritisch naar zichzelf en hun eigen biases te kijken. Dit hebben ze vervolgens gebruikt om een ijsbreker te ontwerpen waarmee ze anderen bewust wilden maken van hun biases. De korte opdracht resulteerde in verrassende en inspirerende ontwerpen. Volgens de studenten had de workshop hen aangewakkerd om stil te staan bij hun eigen biases.

Dit was voor mij het eerste signaal dat zelfbewustwording een goede strategie, een goed ‘frame’ zou kunnen zijn, om het gesprek rondom bias in AI aan te wakkeren.

Het perspectief van AI-gebruikers

Bij de eerstvolgende iteratie greep ik dan ook meteen de kans om dit signaal verder uit te diepen. Waar ik de eerste iteratie gericht heb op (toekomstige) makers van AI-systemen, heb ik deze tweede iteratie gericht op de gebruikers van AI-systemen. Gebruikers die ook niet altijd bekend zijn met hoe en hoeveel biases er in AI-systemen te vinden zijn (Srinivasan). Aan mij de taak om tijdens de co-creatiesessie de participanten bewust te maken van het probleem en de impact die het op hen als gebruiker heeft. Ik gebruikte hiervoor o.a. de role-mapping methode (Boeijen) waarbij ik de participanten bewust maak van de rollen in hun omgeving die zij aannemen en die zij toegewezen krijgen.

“Het feit dat ik op geen hindernis of probleem kan komen als het gaat over technologie doet me realiseren dat ik meer privilege heb dan mijn tafelgenoten“

Ik vroeg de participanten om te bedenken in welke rollen zij hindernissen ervaren met technologie. Dit zorgde ervoor dat de participanten moesten reflecteren op zichzelf, de rollen die zij hebben, en hoe die zich verhouden tot de digitale wereld om hen heen. Daarna introduceerde ik AI en was het aan de participanten om gezamenlijk na te denken over welke behoeften er speelden bij de hiervoor genoemde hindernissen. Het uiteindelijke doel van de sessie was om tot behoeften en richtlijnen te komen die makers van AI-systemen weer kunnen gebruiken om meer inclusieve systemen te ontwerpen.

Gedurende de co-creatiesessie kwam een van de participanten erachter dat hij als witte man zelf weinig van de bias merkt en zal merken in die systemen. Het was voor hem en zijn groepje een doorbraak omdat hij zich realiseerde dat zijn groepsgenoten wel tegen allerlei uitwerkingen van bias aanliepen, waar hij blind voor was.

Deze doorbraken en bewustwordingen zorgden er vervolgens voor dat de participanten betrokken en bewust waren van de potentiële problemen die bias in AI-systemen met zich mee brengt. Dit konden ze toepassen om tot behoeften en richtlijnen te komen die zouden leiden tot meer inclusieve AI-systemen. Deze behoeften en richtlijnen waren in eerste instantie bedoeld voor de AI makers van nu en de toekomst; de ontwerpers, data scientists en developers. Tegelijkertijd hielpen deze behoeften en richtlijnen ook bij het zelf bewustwordingsproces van de participanten. Zij verkregen overzicht en konden met elkaar in gesprek gaan over de behoeften en richtlijnen waarvan zij dachten dat elke AI maker en AI gebruiker die zou moeten weten.

Tools voor verbetering

Met mijn derde iteratie ging ik door op de focus van zelfbewustwording en besloot ik om in mijn workshop aan de toekomstige AI makers, vierdejaarsdesignstudenten van Avans Hogeschool, dan ook de richtlijnen die uit de co-creatiesessie zijn gekomen mee te nemen. Ik ben tijdens de workshop dieper ingegaan op zelfbewustwording en hoe ze anderen zelfbewuster kunnen maken op basis van de inzichten die ik had vergaard uit de eerdere iteraties. Hiermee wilde ik de studenten bewust laten worden van de ervaringen van de gebruikers zodanig dat zij die kennis mee nemen in hun ontwerpen en ontwerperschap.

Ditmaal liet ik de participanten in de opdrachten samenwerken om een ‘Bias in AI’-checklist te maken, waarbij het doel was om zichzelf en anderen bewust te maken van biases. Vervolgens liet ik ze een ontwerp maken voor een concept of tool om de zojuist gemaakte checklist beter of leuker te maken.

Zelfbewustwordingsframe in zicht

Tijdens de laatste iteratie realiseerde ik me twee dingen. Ten eerste realiseerde ik me dat door bias in AI in het zelfbewustwordings-frame te plaatsen, mensen meer open stonden om na te denken over hun bias en te ontwerpen om het tegen te gaan. Ten tweede dat ik in een volgende iteraties graag meerdere malen met dezelfde groep zou willen werken.

Waar mijn iteraties tot nu toe elke keer voor een nieuw publiek waren, merkte ik dat de diepgang die ik inmiddels zoek beter bereikbaar zou zijn door meerdere contactmomenten met dezelfde groep participanten. Ik hoop dat dit mij in staat stelt om eerst een stukje bewustwording te creëren, en op een later moment, waarop deze bewustwording meer onderdeel is geworden van het denkproces van de participant, door te kunnen pakken met co-creatiesessies waarin ik makers en gebruikers samen laat creëren.

Het creëren van golven

Mijn hoofddoel is dat de makers door zelfbewustwording een kritische houding krijgen, die zij meenemen tijdens het maken van AI-systemen. Deze kritische houding, een spiegel voor je eigen biases, zal je zo nu en dan voorgehouden moeten worden om scherp te blijven zodat je je zelfbewustzijn continu blijft aanwakkeren.

Uiteindelijk wil ik, dat na de zelfbewustwordingsstap, mensen geactiveerd worden. Wat gaat er gebeuren als anderen mijn tools en methoden kunnen gaan inzetten bij hun werk, hun projecten, en hun producten? Ik ben aan het uitzoeken hoe ik mijn tools en methoden publiekelijk toegankelijk kan maken, waarbij ik gebruikers van mijn tools en methoden wil stimuleren om de resultaten beschikbaar te stellen voor mijn onderzoek.

Hiermee wordt het een publiekelijk, iteratief proces en ben ik straks niet meer de enige die kiezelsteentjes in het water gooit, en kunnen het effect en daarmee de bewustwording en impact, groter en groter worden.

Bronnen & Noten

Boeijen, Van Annemiek, Culture Sensitive Design: A Guide to Culture in Practice (Laurence King Publishing, 2020), p.109

Perez, Caroline Criado, Invisible Women: Data Bias in a World Designed for Men (Abrams Press, 2019), p.128, p.139

Golnoosh, Farnadi, Bias and Discrimination in AI (University of Montreal, 5 feb. 2020) https://learning.edx.org/course/course-v1:UMontrealX+IVADO-BIAS-220+3T2021/home

Peters, Jay, IBM Will No Longer Offer, Develop, or Research Facial Recognition Technology (The Verge, 9 June 2020) www.theverge.com/2020/6/8/21284683/ibm-no-longer-general-purpose-facial-recognition-analysis-software.

Puri, Ruchir, Mitigating Bias in AI Models, (IBM Research Blog, 15 Feb. 2019) www.ibm.com/blogs/research/2018/02/mitigating-bias-ai-models

Simonite, Tom.,The Best Algorithms Still Struggle to Recognize Black Faces (Wired, 22 July 2019) www.wired.com/story/best-algorithms-struggle-recognize-black-faces-equally.

Srinivasan, Ramya Ajay Chander, Biases in AI Systems (Communications of the ACM, 1 Aug. 2021) cacm.acm.org/magazines/2021/8/254310-biases-in-ai-systems/fulltext.

Stathoulopoulos, Mateos-Garcia, Konstantinos, Juan, Gender Diversity in AI Research (Nesta, July 2019) www.nesta.org.uk/report/gender-diversity-ai.